摘要:OpenAI采用自我博弈强化学习(RL)技术路线进行深度推演,通过让智能体在与自身不断博弈中自我学习和进化,提升其决策能力和应对复杂环境的能力。该技术路线涉及复杂的神经网络结构和优化算法,旨在实现更高效的智能体训练。OpenAI对此技术路线的深入研究和应用,为人工智能领域带来新的突破和进展。

目录导读:

随着人工智能技术的飞速发展,强化学习(Reinforcement Learning, RL)已成为研究的热点领域,OpenAI作为人工智能领域的领军者,其推出的自我博弈强化学习技术路线,特别是o1自我博弈策略,已经在多个领域取得了显著的成果,本文将深入探讨OpenAI的o1自我博弈强化学习技术路线及其背后的技术逻辑。

OpenAI与强化学习

OpenAI是一家致力于推动人工智能发展的非营利组织,其研究领域涵盖了机器学习、自然语言处理等多个方向,强化学习是OpenAI重点研究的技术之一,它通过智能体在与环境交互中学习最佳行为策略,具有广泛的应用前景。

o1自我博弈策略概述

o1自我博弈策略是OpenAI在强化学习领域的一项重要创新,它通过智能体自我对弈,提升策略质量,无需人类数据或监督信息,这种策略在围棋、游戏AI等领域取得了显著成果,展现了强大的潜力。

OpenAI自我博弈强化学习的技术路线

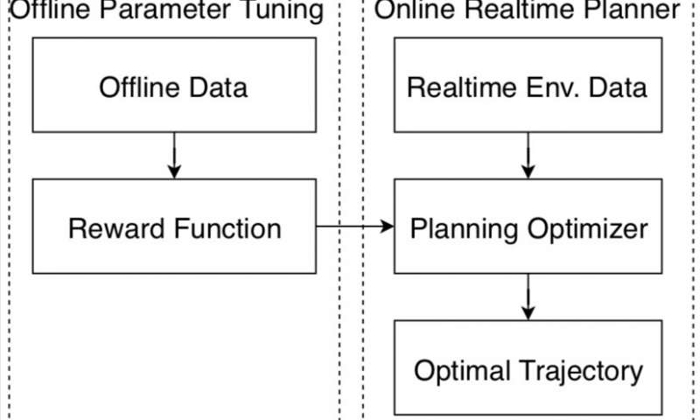

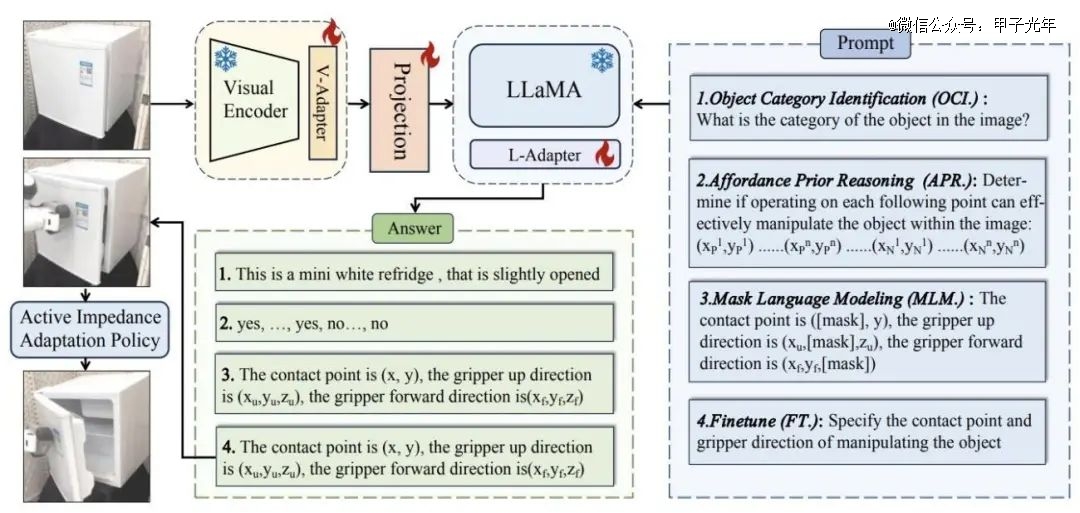

OpenAI的o1自我博弈强化学习技术路线主要包括以下几个阶段:环境建模、智能体设计、策略训练、自我博弈、策略优化和评估反馈,在这个过程中,智能体通过与环境的交互,学习并优化行为策略,最终实现对任务的自动化执行。

技术路线推演

在OpenAI的o1自我博弈强化学习技术路线的推演过程中,有几个关键步骤值得关注:

1、环境建模:准确的环境建模是强化学习的前提,它决定了智能体能获取的信息和能采取的行动。

2、智能体设计:智能体的设计直接影响到强化学习的效果,包括感知、决策、行动等多个方面。

3、策略训练:通过大量的数据训练和算法优化,使智能体学会如何行动以达到预期目标。

4、自我博弈:在自我博弈过程中,智能体不断提升策略质量,通过自我对抗来优化策略。

5、策略优化和评估反馈:根据自我博弈的结果,对策略进行优化,并通过评估反馈来调整训练过程。

技术挑战与解决方案

在OpenAI的o1自我博弈强化学习技术路线的推进过程中,面临着诸多技术挑战,如数据效率、算法稳定性、计算资源等,为解决这些问题,OpenAI采取了一系列创新策略,如改进环境建模、优化智能体设计、提升训练算法等。

应用领域及前景展望

OpenAI的o1自我博弈强化学习技术已广泛应用于游戏AI、机器人、自动驾驶等领域,随着技术的不断进步,其在智能制造、智能家居、智能医疗等领域的应用前景将更加广阔。

最新进展与未来趋势

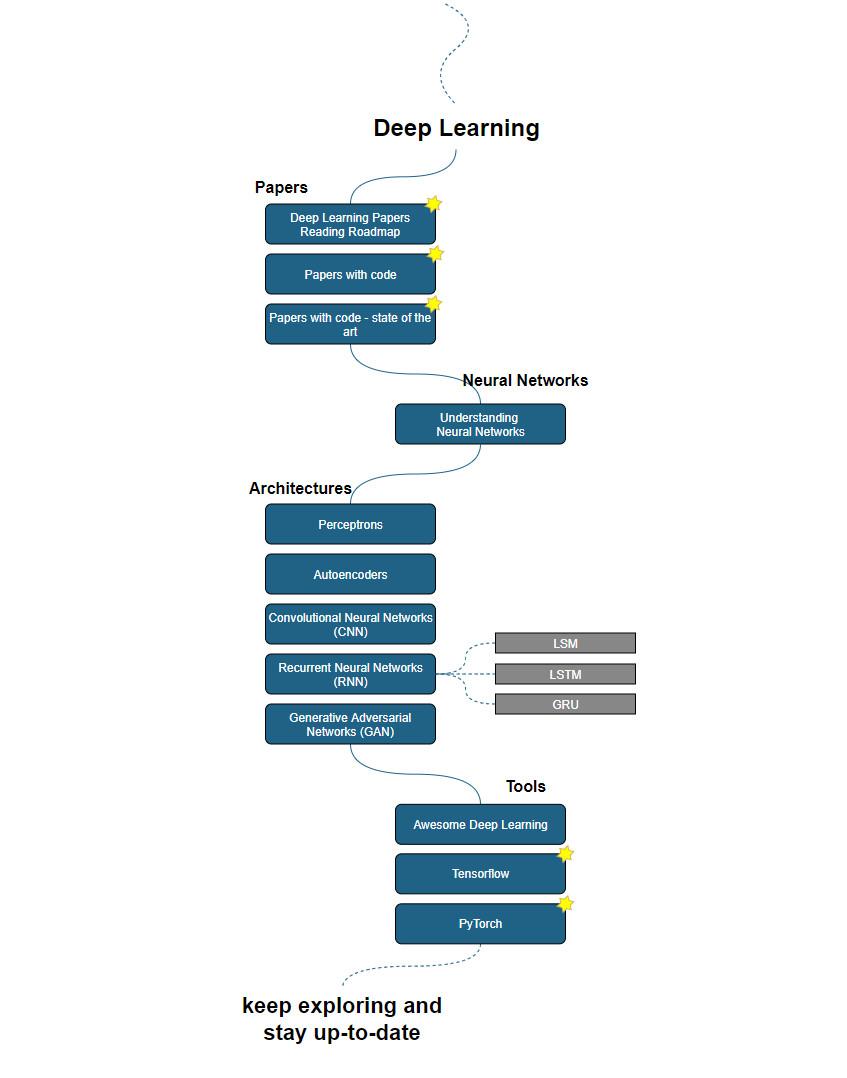

近年来,OpenAI在o1自我博弈强化学习领域取得了显著进展,随着深度学习、神经网络等技术的不断发展,OpenAI将继续探索更高效的训练算法、更智能的感知与决策机制等,推动自我博弈强化学习的进一步发展。

OpenAI的o1自我博弈强化学习技术路线为人工智能领域的发展开辟了新的道路,通过智能体的自我博弈,实现了策略的自动优化,提高了智能系统的性能,这一技术路线的成功实践为人工智能在其他领域的应用提供了有益的启示和借鉴。

OpenAI的o1自我博弈强化学习技术路线在人工智能领域具有重大的意义和价值,随着技术的不断进步和应用领域的拓展,我们期待这一技术路线在未来能够取得更多的突破和创新,为人工智能的发展注入新的动力。

转载请注明来自徐州满江红科技有限公司,本文标题:《OpenAI o1自我博弈强化学习(RL)技术路线的深度推演》

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号