DeepSeek R1推理模型完全本地部署保姆级教程,断网运行,无惧隐私威胁,大语言模型推理时轻松调参,CPU GPU混合推理,32B环境轻松部署

摘要:本教程详细介绍了DeepSeek R1推理模型的本地部署过程。该模型可在断网状态下运行,保障隐私安全。教程提供保姆级指导,轻松调参,支持CPU和GPU混合推理。即使在不连接网络的情况下,也能实现大语言模型的推理,为用户提供更加便捷、安全的体验。32B环境下轻松完成部署,适合各种场景的应用。

目录导读:

随着人工智能技术的飞速发展,大语言模型的应用越来越广泛,DeepSeek R1推理模型作为其中的佼佼者,具备强大的自然语言处理能力,本文将为大家呈现DeepSeek R1推理模型的完全本地部署保姆级教程,让你在无网络环境下也能安心运行,远离隐私泄露风险,我们还将介绍如何在本地环境中轻松调整参数,实现CPU与GPU混合推理,以及如何在32B环境下轻松部署。

准备工作

在开始之前,你需要准备以下事项:

1、一台性能良好的计算机,支持安装深度学习框架和GPU驱动(如有需要)。

2、足够的存储空间来安装DeepSeek R1推理模型及相关依赖库。

3、了解基本的计算机操作和编程知识。

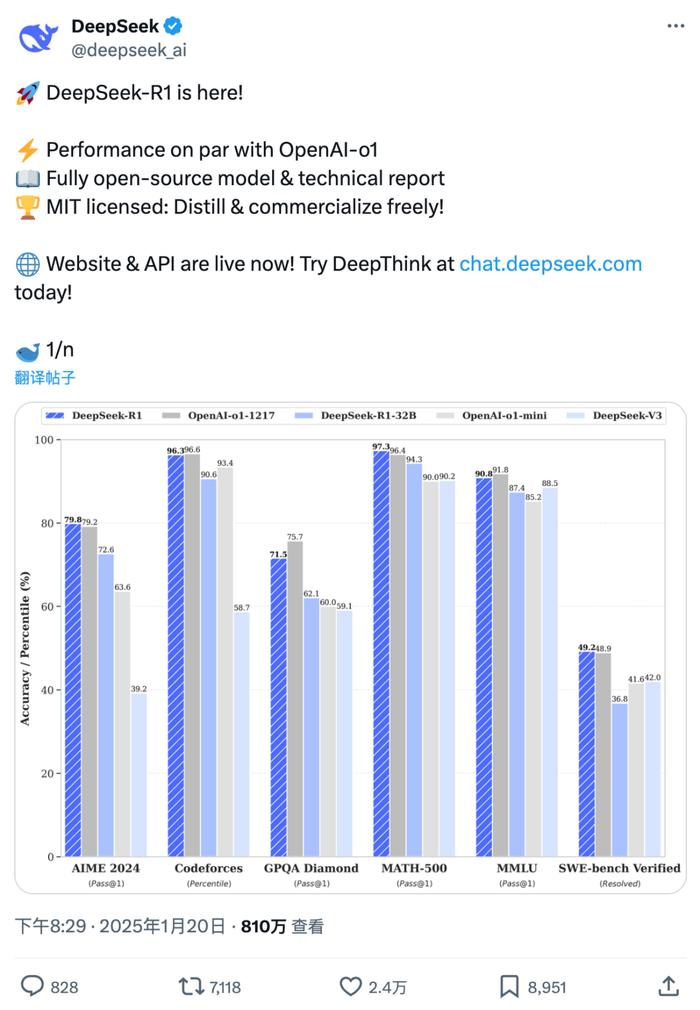

DeepSeek R1推理模型简介

DeepSeek R1是一款高效的大语言模型推理工具,支持多种任务,如文本分类、情感分析、问答系统等,其强大的性能得益于深度学习和自然语言处理技术的结合。

四、完全本地部署DeepSeek R1推理模型

1、安装深度学习框架:根据你的需求选择安装TensorFlow或PyTorch等深度学习框架。

2、下载DeepSeek R1模型文件:访问官方网站或相关资源网站下载DeepSeek R1模型文件。

3、配置环境:根据模型的要求配置相应的环境,如Python版本、依赖库等。

4、运行测试:完成配置后,运行测试脚本,确保模型能够正常运行。

断网运行与隐私保护

完全本地部署DeepSeek R1推理模型后,即使在没有网络的环境下也能正常运行,这将有效保护你的隐私,避免数据泄露风险,本地部署还可以提高数据处理速度和安全性。

大语言模型推理时的参数调整

DeepSeek R1推理模型支持多种参数调整,以优化性能和准确性,你可以根据实际需求调整以下参数:

1、批处理大小:调整一次处理的样本数量,以充分利用计算资源。

2、学习率:调整模型训练时的学习率大小,影响模型的收敛速度。

3、训练轮数:决定模型训练的次数,影响模型的泛化能力。

4、其他高级参数:根据具体情况调整其他高级参数,如优化器类型、正则化方法等。

CPU与GPU混合推理

DeepSeek R1推理模型支持在CPU和GPU上进行混合推理,如果你的计算机配备了GPU,可以通过配置环境使用GPU加速推理过程,对于某些任务,CPU推理也是可行的,你可以根据实际情况选择合适的推理方式。

八、在32B环境下轻松部署DeepSeek R1推理模型

部署DeepSeek R1推理模型时,确保你的操作系统和环境满足模型的最低要求,在32B环境下部署时,需要注意以下几点:

1、选择合适的Python版本和依赖库。

2、确保模型的输入和输出格式与预期一致。

3、根据需要调整模型参数和优化设置。

常见问题与解决方案

在部署和运行过程中可能会遇到一些问题,下面列出一些常见问题及解决方案:

1、模型无法加载:检查模型文件是否完整,路径是否正确。

2、运行速度缓慢:尝试调整参数优化设置,利用GPU加速推理。

3、隐私泄露风险:确保完全本地部署,避免将数据上传到云端。

本文介绍了DeepSeek R1推理模型的完全本地部署保姆级教程,包括断网运行、无惧隐私威胁、大语言模型推理时轻松调参、CPU GPU混合推理以及32B环境轻松部署等内容,希望本文能帮助你顺利部署和运行DeepSeek R1推理模型,为你的项目带来便利和效益,随着技术的不断发展,未来DeepSeek R1推理模型将会有更广泛的应用和更强大的性能。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号